生成對抗網路 Generative Adversarial Nets(GAN)詳解

生成對抗網路 Generative Adversarial Nets(GAN)詳解

近幾年的很多演算法創新,尤其是生成方面的task,很大一部分的文章都是結合GAN來完成的,比如,影象生成、影象修復、風格遷移等等。今天主要聊一聊GAN的原理和推導。

github:

http://www。

github。com/goodfeli/adv

ersarial

論文:

https://

arxiv。org/abs/1406。2661

背景介紹

在GAN演算法出來之前,關於生成的task表現一直都不太好,因為之前的方法由於在最大似然估計和相關策略中出現的許多棘手的機率計算難以近似。而GAN呢,直接繞過了這些問題,用兩個對抗的網路對資料進行生成對抗學習,透過零和遊戲的形式來直接用網路來擬合數據的分佈,從而對資料進行生成。(統計學裡,任何資料都可以看成分佈,任何資料都是同不同的分佈中進行取樣得到)

零和遊戲的概念主要出現在博弈論裡面,核心思想就是,兩個玩家進行對抗遊戲,最後會陷入一個那納什均衡的狀態。什麼是納什均衡?就是說最後兩個玩家,他們都會選擇最優的策略進行遊戲,但是當兩個玩家只要有一個人的決策從這個“最優決策”裡跳出來,那麼他就得不到最多的好處。透過這種方式,實現最終的平衡。而這一思想也深深的滲透到這個演算法之中。

這兩個網路,一個是生成器(generator)一個是判別器(discriminator),生成器G的角色就是要學習到資料的分佈,能夠實現生成以假亂真的資料。而鑑別器D的目的就是要鑑別資料的來源是真實的樣本分佈還是透過生成得到的。G和D之間的對抗,主要是:1。G想要騙過D,就是讓D分辨不出來這個資料是從真實樣本里來的還是從G生成的;2。D的目標就是分辨這個資料到底是G生成的還是真實的樣本。

目標函式

生成對抗網路的核心就是極小極大遊戲( two-player minimax game),這裡G是生成器,生成假資料,D是鑑別器,可以理解為二分類的分類器(當然後面有很多變體,這裡不討論),對應的目標函式如下:

![\min _{G} \max _{D} V(D, G)=\mathbb{E}_{\boldsymbol{x} \sim p_{\text {data }}(\boldsymbol{x})}[\log D(\boldsymbol{x})]+\mathbb{E}_{\boldsymbol{z} \sim p_{\boldsymbol{z}}(\boldsymbol{z})}[\log (1-D(G(\boldsymbol{z})))]](https://img.heatask.com/upload/website_attach/Iuw42jhFNcyh6U2=K46O4_Wxet2w4R9p6dO400zwb_p-7ahAgYeW4HtydQZQVm1-ivUMs8HY0LZirTCAgvDaDrJaqs+k5nfwqWoBtQuXOJm-3S6AgYeW20wNe4qkjjvxqWJCmILTK+9zx-sl+5qKsHunItakjjviqWJCtILRK_dlJ9UWcQL-p6WSw=Vko_KEqWJyH_aQm7x-iS6AgvpYhnQYhY_J6RrqK=BEGizkvnuW7fqvwhLJfqW-xhZ_V6pzxtYlHIVZvn=iqLLBd4zV3_gwIdr-6cphxLQAaQpXOJm-im6A1blYe9gWeeVFIhu-ivoNs8vZMc9hxoq5UtDk5iwK6dtJ6Rq-ivops8vZsc9zxUa9+VVm1+W-w-Z_VRvQJ5w_40R70iL-iSspoWvaDrJapWqR8r9Uf4HDHjeU0LlQJfqvULCYejUY2wckjjK-iYnAaLek0i5EqLvs1VRaDrnUxQZeQcpzxtol1_qJ3LQeJ-rAgvDADrJapWqS8ru_qWnts8HZf.jpeg)

![\mathbb{E}_{\boldsymbol{x} \sim p_{\text {data }}(\boldsymbol{x})}[\log D(\boldsymbol{x})]](https://img.heatask.com/upload/website_attach/Q7wsR6M8GgL3747Eo0tMQ4WqQp+9MtcZT_Osji9Eg5SlnEtNjk3A_cwYQKVMOvqPkOJyhsU=Tjw1k38F61FQ-bu=TpzMOvq=kOJyksUsT5OpKTNZ+hNtFSW6BqCMfuxGkOJi_KFvb-tl_1VNj3EC+-QMuyu=ctaaSqBCiJ9A7UeCnNa=WPNj5xWnC5y6R-YvFpYA_stP7UJ4r-eOI0dFj4gpT_WrchYtFaQO37QNHRVl_wVC_.jpeg)

的意思就是對真實的資料分佈進行取樣,然後求函式

的期望。

![\mathbb{E}_{\boldsymbol{z} \sim p_{\boldsymbol{z}}(\boldsymbol{z})}[\log (1-D(G(\boldsymbol{z})))]](https://img.heatask.com/upload/website_attach/aCiDrOCKpXlzH29ycBVtYA6z8CDvsO7pdp=DprA5AyeS0lB_B6TQWo+58D1tTC0xJIZi7Zn2gbJP+10zZCaZcnPZMC6tTC0vJIZiHZn0gyxtmRiIVYez_Z6CfC25pAdbepmVqzo=EN154SLQ+Jr-+f2P3eo=7F=RZCFCqr5uWxJz+75_BOZS9bojVAetTJH-NKFPqzHqdI0gBRCQ+JMgjV6VW-KHZO0QbBiw9rzhWPKSWH01+Jr-+f2y3e13m+H_JIUiW.jpeg)

同理,從高斯噪聲中進行取樣,並且求

的期望。

整個目標函式是透過交替迭代最佳化的形式,來對G和D進行更新,很像就是兩個人下棋一樣,你一下我一下。這樣想就會比較好理解。 這裡首先更新D,所以我們將G的引數都看成常數,那麼目標函式就變成:

![\max _{D} V(D, G)=\mathbb{E}_{\boldsymbol{x} \sim p_{\text {data }}(\boldsymbol{x})}[\log D(\boldsymbol{x})]+\mathbb{E}_{\boldsymbol{z} \sim p_{\boldsymbol{z}}(\boldsymbol{z})}[\log (1-D(G(\boldsymbol{z})))]](https://img.heatask.com/upload/website_attach/9CGNmCC3VrQeAZO+Ck9TGk1IFOxISdl5mpINLpAgMYmnBJZ7ounJM=qxEWsbmE2fkNm=pbnWLJMn-sVw093MZ11H3wsZmdZ9mB8b8bnP4v1nnW4gy4Aru25oFFx+=arZLpOiMxnP4iqnnW3wy4v70Xd6iPqyOsO72IuSGBryynannWiDlDHHvr1e3wsbG9vqVx2OfP5hOxmHB=a1FZ46YVNfh+P7OsgZ2IFT3Irw_25oEkxSzXG6NGqnrJ8HDdtuMyej8AAi_2E9Bosd0p3MZ11c3wsLm2vVePkaGBdaBM1eGss7oXHzu2E9h+D6tYwc8C7gMp5hOn1eG_S7oXGUu25oNO6IPepC2IFx3IrRBwQKlV8fFlP+Hn1e25SK7b2fkNmRAdcQ9462EY=DAafJMwQKh+PqA2vXfx2XW+nP5n1cGmsbHZ5+mrankcGtS=2fFd8C3I4y_25o=xxJDWneHtNJCwsbmTRfkNmRAdqQWG4n-Hl7ouGK9.jpeg)

目的是最佳化能夠讓這個目標函式最大化的D的引數,所以是

。那既然是max這個目標函式,那麼我們就可以知道

越接近1越好,對應的

就是越接近0越好。那麼咱就可以理解了,這個時候G是不動的,看成常數,對應的就是更新D的引數,D呢就是要分出真實資料和生成的資料,分的越開越好。 然後我們再更新G,那麼對應的目標函式,現在變成這樣:

![\min _{G} V(D, G)=\mathbb{E}_{\boldsymbol{x} \sim p_{\text {data }}(\boldsymbol{x})}[\log D(\boldsymbol{x})]+\mathbb{E}_{\boldsymbol{z} \sim p_{\boldsymbol{z}}(\boldsymbol{z})}[\log (1-D(G(\boldsymbol{z})))]](https://img.heatask.com/upload/website_attach/PrOmPoLepCJLPfY+aXH7OX=Jw9WIKeDtgT4mNQ80AHO3ypM7Ft8uODfkUElbNFOKM8NojqX5qgF5itenfaOsX1EopruKsl8IN-O6B7+5EMYuitZoxms05H=dz9QfUa4MhTqzOrU5EMYMitZofmsG5bLwVz7sRHsbuNgG48Q5ZLNJitZ8VYomC4KoDruKsc3KYPEs9gCOWGiQOfvKkXx5j5zLYtlbOLsLmgg05v-Lgyg83eTIVmJ=j5_+cgA6SZx+Ors2OQI1WEgL3-O7Fa3sX1EoDiuK6FhKM_suBRQIx8X38cepevP=BL=fzClZNeifyqOOzQ0OWGh38ceQevP=QL=dzLMSUsJsCFg04A-LgGYHNaiGaFazPaloDrQ_YtP7Qhx=_y+Gdjj4AZpJVZ82PDjKVtlbN-SKM8NsWCx5EMN38ld7Ft85Paykcgjc6sa7QhX15l-AFEg83eeIXY4OgDc3V9DKsci_Qhx=_y+HdjXmitdfevD=B.jpeg)

這裡同樣的,就把D看成常數,咱只更新G的引數,所以這回G是主角。這個目標函式就是說優化出最小化目標函式下,對應G的引數。由於D在這是常數,所以咱就把前面半個公式撇了,可得:

![\min _{G} V(D, G)=\mathbb{E}_{\boldsymbol{z} \sim p_{\boldsymbol{z}}(\boldsymbol{z})}[\log (1-D(G(\boldsymbol{z})))]](https://img.heatask.com/upload/website_attach/PrOmPoLepCJLPfY+aXH7OX=Jw9WIKeDtgT4mNQ80AHO3ypM7Ft8uODfkUElbNFOKM8NojqX5qgF5itenfaOsX1EopruKsl8IN-O6B7+5EMYuitZoxms05H=dz9QfUa4MhTqzOrU5EMYcitZofmsG5bLwVz7sRHsbuNgG4rI1W9OFyBm1XctsLYjScgg7YtP7QhX1_ykux8J0BbFfXFi4Pq=fzeUKsc3KYP_s9pj5ERX38lFJXcOoj5_+pzd7YthcvFgNLv-LgGYHNaiGaFazPaloDrQ_YtP7QhX2_y+HdjXmitUoB.jpeg)

為了最小化這個目標函式,這個時候,G就要最佳化自己,讓

的生成結果儘可能的得到較高的分數,及

越接近1越好,所以對應的你會發現

被最小化,如果

趨近於1。 然後兩個模型繼續迴圈往復迭代,你一下,我一下。。。。

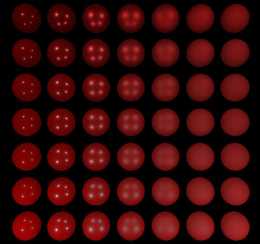

那麼如果是這樣訓練下來,這個過程中他們的分佈是怎樣變化的呢? 理想狀態下,他們的關係如下:

這裡直接放了論文裡的圖,

是高斯噪聲的域domain,

是真實樣本的域。黑色的點表示真實樣本的分佈

,藍色的點表示分類器分類的表現;綠色的線表示生成資料的分佈

,由噪聲

透過

對映而來。(a)一開始分類器的表現,好像能夠大概分開兩個分佈的樣子。(b)對D進行最佳化,那麼D達到了最優的分類狀態

。(c)這個時候G透過D的引數,進一步對自身最佳化,然後往真實樣本進行靠近。(d)最終,生成模型生成的資料和真實樣本一致,鑑別器D無法準確劃分,

。

訓練虛擬碼

這裡的虛擬碼已經在目標函式上進行了解釋,主要這裡更加詳細,實際上就是目標函式部分解釋的內容,

就是對應鑑別器引數的梯度,這裡用隨機梯度下降法對模型引數進行更新,根據目標函式。

同理,是生成器G的引數梯度,結合上述

目標函式

進行理解。

理論推導

咱這裡直接順著論文的順序,進行進一步的梳理。首先是上面提到的,為什麼當G固定的時候,最優的D應該是如下形式:

論文也給出了對應的證明,這裡著重給出對應的解釋: 首先我們回看

目標函式

,求期望實際上也可以寫成這種積分的形式:

這裡可以看到後半部分稍稍改動了一下,就是說直接將

進行替代,對

進行取樣等價於對

進行取樣,所以就可以寫成下面的式子,這裡需要注意的是我們並不知道

和

的真實分佈。不過我們能夠知道

和

都是屬於[0,1]之間的值,我們要求的就是

的值,這個公式下,我們將其替換成如下形式:

我們把

,然後這裡就變成關於

的一個函式。然後我們要記得的是,在G固定的時候,為了求得最大化下的D的引數,所以就是最大化這個

。可以知道這個

是一個凸函式:

有個定理就是說,如果

是正定矩陣,那麼他就一定是凸函式。這裡就是把向量簡化成了標量。注意因為我們這裡是求極大值,加上一個負號就是求極小,這個二階導加一個負號就是正定矩陣(原本是負定)。說了那麼多直接畫個圖好了:

這裡可以看到假設

出來的圖就是這副樣子。 令

,可得

,相當於極值就是這個。這裡就是說明了當給定任意的G,在這一步最優的D的最優解就應該是

,即

。 好的,這裡已經證明在最佳化D的時候,D應該是什麼樣子,接著我們再看看如果是再最小化目標函式是,固定D的時候,G應該是多少呢?先給出公式

![\begin{aligned} C(G) &=\max _{D} V(G, D) \\ &=\mathbb{E}_{\boldsymbol{x} \sim p_{\text {data }}}\left[\log D_{G}^{*}(\boldsymbol{x})\right]+\mathbb{E}_{\boldsymbol{z} \sim p_{\boldsymbol{z}}}\left[\log \left(1-D_{G}^{*}(G(\boldsymbol{z}))\right)\right] \\ &=\mathbb{E}_{\boldsymbol{x} \sim p_{\text {data }}}\left[\log D_{G}^{*}(\boldsymbol{x})\right]+\mathbb{E}_{\boldsymbol{x} \sim p_{g}}\left[\log \left(1-D_{G}^{*}(\boldsymbol{x})\right)\right] \\ &=\mathbb{E}_{\boldsymbol{x} \sim p_{\text {data }}}\left[\log \frac{p_{\text {data }}(\boldsymbol{x})}{P_{\text {data }}(\boldsymbol{x})+p_{g}(\boldsymbol{x})}\right]+\mathbb{E}_{\boldsymbol{x} \sim p_{g}}\left[\log \frac{p_{g}(\boldsymbol{x})}{p_{\text {data }}(\boldsymbol{x})+p_{g}(\boldsymbol{x})}\right] \end{aligned}](https://img.heatask.com/upload/website_attach/MFaH89A5tCv1b1rPGtYurA71pz=ypN7wH7jHqUEiwHatc=FikdwZqnHK8dIAgESvM7r5pUfS-MZp_OfxVi9jDbp70KHFdfwD4eJlrUUgHmutBGGj2bLR1C9uDfYldf0l5AZ=lzolGjJ=+RK_3UIVwZ7CdVIEgNCgHEVhoP6za-etBGbL2bLU0fqvpC=PkAw4m7murD6zaJktBGau2b7Q9NT41g-8dfLB4eJl98pg8EytBGGJrKdY1V7GdVIAhUI2I-e0bmnSoJZtBTmikdwh8NG7dwtgEB0G4erDH_pUGjrA+RGS2bLR0f3H0K7hxE=vLFT4rU3_qEe1_6VikDcjDbpuw7wUVnLnH-e0cD6YayeH_0AWm=YZpZ7GcpIgEBde4erBH_pTn8vuXm-OLJ0g8U7Gcs5gEBcq4eJl8mSQHHRd+R8T2b7QpEF3qOwCWn0um-e2bIsS-MZtBGaikDcjwIW3qrqDdf7B4eJlr8EvHCeH_0Ii80cjDbbSl7d8dfLBIke2cD6Pb_e1_gfxeaIOdU7BxU9gqbX=W+ThrmnorHhvWLsz2bLUMZ7GdVIUFeIPXde0bG3toGVG+RmO2b7Q9ETIrOcgEIcq4eJlH_pTHCeOBgfkfRICcNyOLNYVxZI2+Ke=UL+0GjrA+RK_rt=hqAW08r0OWUI2+3k=ULflGjJ=a0ig3A-m0fHD0K7hYF73H-y=UL3onxazIOfCfRIOdU7GdVIEgNK=L3Z=UQ2S-RTuZ0ruf_tjwB490KLidf7E4erBH_3xGjrl+RmN2b7QpEF3qOwCWn0um-e2bIaS-MZt9iJikdwVrnHJLVIEhUIP+Ye0bmPb89VgWgfCe+IjwBIa0KLRdf7l9Dvvp9Vhqwm5ZAfCe0XjwB+70K7hXNjs5NReH_GkoCe1jAfCfRICcNouqscgEIH=W+TvrmmlGjJ=ZMKlmRIVxQU4dwtgEB0G4erDH_pUGjrA+RGS2bLR0f3H0K7hxE=vLFT4rU3_qEe1_6VikDcjDbpuw7wUVnLnH-ePwi6PaHmnX0WF2b7R1V7McZIEgVh=Ba7=lLfS-RTvWVb3rtHjwB4t0KLiwVI2+Ye0bm3_q9aPckAXLFJjwB4H0KLieVI0+NToriQ77Ce1_gfAeAdjMA+70KLRkFSH9dy=ULfS-MZtBGaikdwhqnLL0K7Rdf7lmEv70B6PaGnOWk=ikD0JoV7GcdIEgOd=0FZqH_Gko9jGWQzikDcjwB+uDfXgEIwhmC+x8GSQn8vu+R8TGRIOdU7BxJIAhUI2+_ReH_GkGjJ=bMKNmRhjwB4Tp8dkeVI2I-e2cD6YUEeH_0GyL=dWMnyP8zJgEB034erDH_2hGjmAaDvikD040fHs0KHBdf7l9Dvvp9Vhqwm5ZAfCe0XjwB+uDf6gEBc=W+TPqUGs8EeHjAfxeVICcNyOLNYVxZI2+Ke=UL+0GjrA+RK_rt=hqAW08r0OWUI2+3k=ULflGjJ=a0ig3A-m0fHDqZIAhUI2I-e0bmnSoJZtBTmikdwh8NG70K7hk40g9ke2bIx0GjrAXOfCfRIVxU7Mcz0OWFdy07Fhrm7S-Mm2+R8j2bHy0fHs0KLRXSt=WAM=UQVOoxVGIOfCetdYLFU70KLidfLD4eM3H_pTn8vuXm-OLJ0g8U7GcsXgEBc=BaI=lT377Ce1_LrikDcjDbbuw7wVWNKxGNhsorEjGjrAcAfCfRIVxe7GdVIEgO0oLCVHH_p-HCeH_0KP8RIOcEw3rrLNknc=WAZtV.jpeg)

這裡公式的意思就是假定

已經算完了,那麼接下來要繼續最小化

,G的應該是什麼樣子的呢? 上面的公式已經將

給帶掉了,就是假定我們已經最佳化過了D,直接將上面的結果帶入就可以得到最後一條公式:

![C(G)=\mathbb{E}_{\boldsymbol{x} \sim p_{\text {data }}}\left[\log \frac{p_{\text {data }}(\boldsymbol{x})}{P_{\text {data }}(\boldsymbol{x})+p_{g}(\boldsymbol{x})}\right]+\mathbb{E}_{\boldsymbol{x} \sim p_{g}}\left[\log \frac{p_{g}(\boldsymbol{x})}{p_{\text {data }}(\boldsymbol{x})+p_{g}(\boldsymbol{x})}\right]](https://img.heatask.com/upload/website_attach/QIMoQf+x+2jptUwYU78Xtwg9SneLa7i2Tzfo_PeovJMG=aqeVyN7MpgttFMMv.jpeg%3D%5Cmathbb%7BE%7D_%7B%5Cboldsymbol%7Bx%7D+%5Csim+p_%7B%5Ctext+%7Bdata+%7D%7D%7D%5Cleft%5B%5Clog+%5Cfrac%7Bp_%7B%5Ctext+%7Bdata+%7D%7D%28%5Cboldsymbol%7Bx%7D%29%7D%7BP_%7B%5Ctext+%7Bdata+%7D%7D%28%5Cboldsymbol%7Bx%7D%29%2Bp_%7Bg%7D%28%5Cboldsymbol%7Bx%7D%29%7D%5Cright%5D%2B%5Cmathbb%7BE%7D_%7B%5Cboldsymbol%7Bx%7D+%5Csim+p_%7Bg%7D%7D%5Cleft%5B%5Clog+%5Cfrac%7Bp_%7Bg%7D%28%5Cboldsymbol%7Bx%7D%29%7D%7Bp_%7B%5Ctext+%7Bdata+%7D%7D%28%5Cboldsymbol%7Bx%7D%29%2Bp_%7Bg%7D%28%5Cboldsymbol%7Bx%7D%29%7D%5Cright%5D)

咱現在就是要最小化這個公式(最佳化G),這裡再把它寫成積分的形式:

因為

並不是一個分佈,求積分=2,所以這裡要改成如下形式,才能套到KL散度的公式中:

然後把

提出來:

這裡就可以看到兩個KL散度,KL散度是大於等於0的,只有當兩個分佈完全一樣的時候,KL散度才等於0。這裡又可以進一步轉化變成對稱的JS散度:

只有當

的時候,我們才能得到這個式子的最小化結果就是

。 所以可以看到最終這個目標函式,能夠讓G不斷擬合分佈,使得生成的資料的分佈接近真實樣本的分佈。

當然GAN現在發展已經好幾年了,已經有很多最佳化的方法被提出,下次再討論~

如果覺得不錯,可以關注微信公眾號,搜尋: DeepGo

一起來學習前沿且優秀的工作!!

轉載請註明出處,尊重勞動成果,維護美好社群謝謝!

上一篇:你有過哪些血槽已空的經歷?

下一篇:如何從不會拍照到拍照好看?